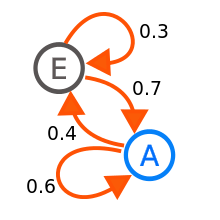

Introducción a la utilización de los modelos de Markov en el análisis farmacoeconómico | Farmacia Hospitalaria

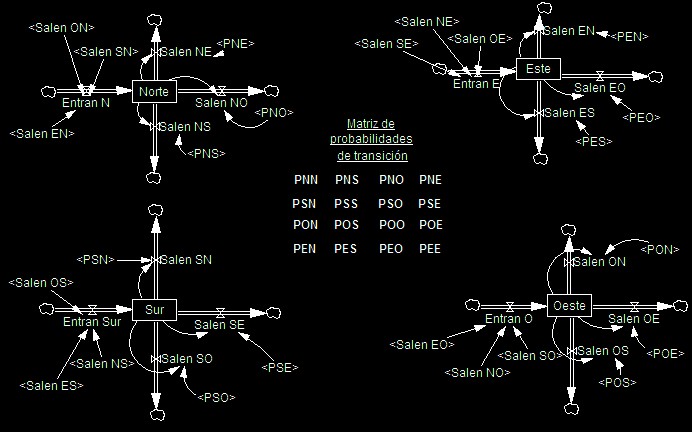

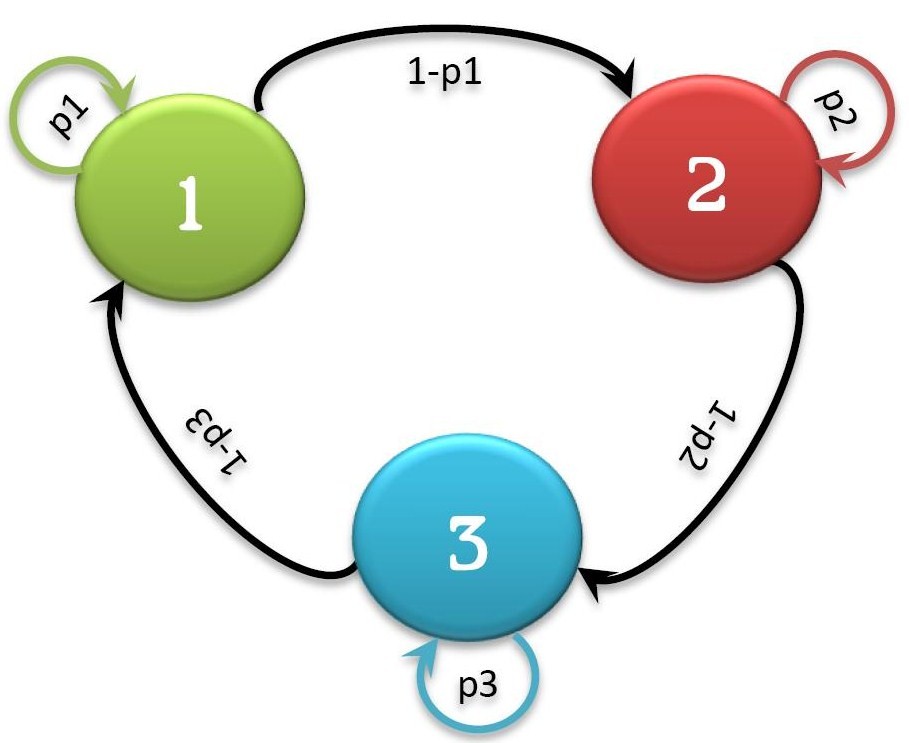

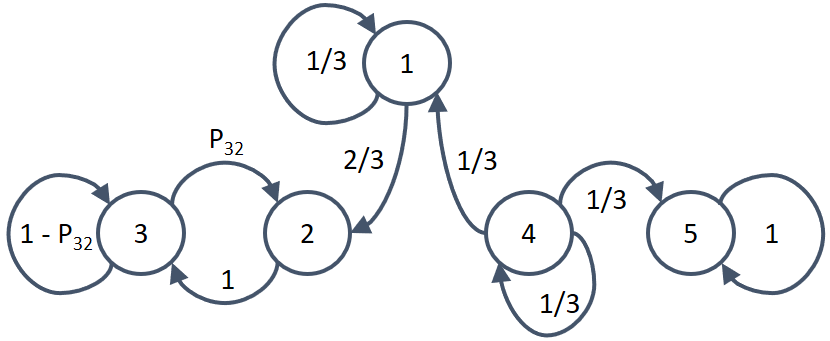

MUNDO IO - Investigación de Operaciones - Las Cadenas de Markov en Investigación de Operaciones son útiles para aplicaciones donde es más importante los comportamientos recientes, y a partir de ellos estimar